车载摄像头模组是如何感应前方物体距离的

车载摄像头模组通过单目视觉算法、双目立体视觉、深度学习算法以及多传感器融合等方式感应前方物体距离,具体原理和实现方式如下:

1. 单目视觉算法:基于几何关系的估算

原理:

单目摄像头通过分析物体在图像中的尺寸变化,结合已知的物体实际尺寸或先验知识(如交通标志的标准高度),利用相似三角形原理计算距离。公式:

Hh=df

其中,$h_{\text{图像}}$为物体在图像中的高度(像素),$H_{\text{实际}}$为物体实际高度,$f$为摄像头焦距,$d$为物体与摄像头的距离。

示例:

若交通标志标准高度为2米,在图像中高度为100像素,摄像头焦距为500像素,则距离 d=hf×H=100500×2=10 米。

局限性:

依赖物体实际尺寸的先验知识,若物体尺寸未知(如行人、车辆型号多样),精度会下降。

在复杂场景(如物体重叠、形状不规则)中,计算难度增加。

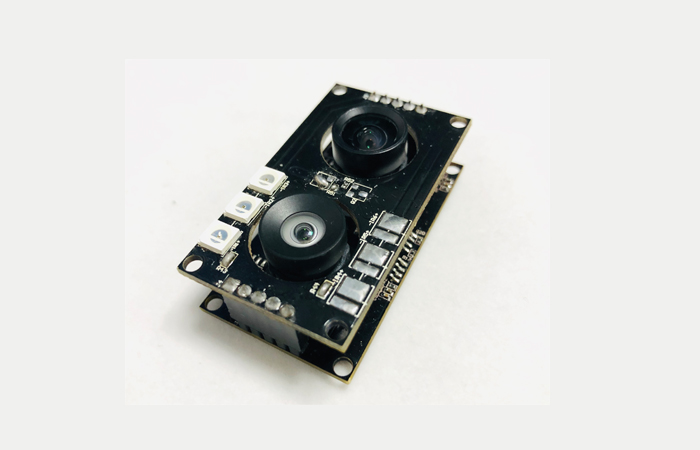

2. 双目立体视觉:模拟人眼视差

原理:

双目摄像头由两个位置不同的摄像头组成,通过比较同一物体在两幅图像中的位置差异(视差),结合三角测量原理计算距离。步骤:相机标定:确定每个摄像头的内部参数(焦距、畸变系数)和相对位置(基线距离)。

双目校正:消除图像畸变,使两幅图像行对齐。

视差计算:通过匹配算法(如SGBM、BM)找到对应像素点,生成视差图。

深度计算:根据公式 d=Δxf×B 计算距离,其中 B 为基线距离,Δx 为视差值。

示例:

特斯拉的Autopilot系统通过车身周围的8个摄像头中的部分摄像头组成双目系统,计算图像中目标物的视差,结合已知的光圈中心距离和焦距,估算目标物到基线的距离。

局限性:依赖摄像头的高精度校准,若光轴不平行或焦距不准确,会导致视差计算错误。

在低光照或物体表面纹理不明显时,匹配算法可能失效。

3. 深度学习算法:数据驱动的预测

原理:

利用卷积神经网络(CNN)等模型,通过大量标注好距离信息的图像数据训练网络,使其学习图像特征与距离之间的映射关系。流程:数据收集:采集包含不同距离物体的图像,并标注真实距离。

模型训练:使用CNN提取图像中的纹理、边缘等特征,训练网络预测距离。

推理应用:输入新图像,模型输出物体距离估计值。

示例:

比亚迪的三目前视摄像头系统中,长焦镜头用于远距离物体识别(如红绿灯),双目摄像头通过视差算法测距,系统结合AI算法识别特定障碍物(如车辆、行人)。

局限性:训练数据的质量和多样性直接影响模型准确性,若数据未覆盖所有场景,模型可能失效。

计算资源需求高,对车载计算单元的性能要求较高。

4. 多传感器融合:提升鲁棒性

原理:

将摄像头数据与毫米波雷达、激光雷达等传感器的数据进行融合,弥补摄像头在距离测量精度和可靠性方面的不足。优势:毫米波雷达在恶劣天气(雨、雾、雪)下性能稳定,可提供精确的距离和速度信息。

激光雷达通过激光束扫描构建环境点云图,提供高精度的三维空间信息。

示例:

奔驰S级搭载的双目立体摄像头与毫米波雷达融合,实现自适应巡航(ACC)和自动紧急制动(AEB)功能。

应用场景与性能对比

车载摄像头模组通过单目视觉、双目立体视觉、深度学习以及多传感器融合等技术,实现了对前方物体距离的感应。单目视觉成本低但精度有限,双目立体视觉精度高但依赖校准,深度学习适应复杂场景但需大量数据,多传感器融合则综合了各传感器的优势,提升了系统的鲁棒性。实际应用中,车企会根据成本、精度和场景需求,选择单一技术或组合方案,以实现安全、可靠的辅助驾驶功能。

全国服务热线

全国服务热线